大多数人在很小的时候就能认出猫或狗。当被问及如何辨别动物是猫还是狗时,成年人可能会通过描述经验来摸索出一个解释,比如“猫在远处评价你,但狗却试图跳到你身上舔你的脸。”

换句话说,我们并没有真正表达出我们所知道的。

过去二十年来,人工智能的标志性成就是通过对猫狗图片进行分类。但人工智能程序从未解释它们如何“知道”它们理应“知道”的东西。他们是众所周知的黑盒子。

谷歌的人工智能研究人员最近的一项创新,试图提供人工智能如何知道这些事情的答案。这是一个令人着迷的工程项目,也让人怀疑人工智能是否真的知道任何事情。

研究论文的解释风格:培训StyleSpace GAN解释一个标识符,“谷歌研究科学家朗奥兰和他的同事们开始逆向工程的一个分类器:机器学习程序开发一种能够自动图片分类,如“猫”和“狗”。

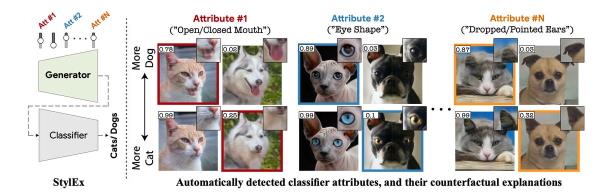

他们的程序名为“StylEx”,它能够识别一些东西,让分类器将给定的照片分配到一个或另一个类别,它的方式是人们可以识别的——换句话说,是语义上重要的属性。

他们的技术采用了一种被称为生成式对抗网络(GAN)的新方法。GAN方法最初是由人工智能科学家约书亚·本吉奥(Yoshua Bengio)和他在蒙特利尔MILA的团队于2014年引入的,是一种非常受欢迎的程序,用于生成模仿给定风格或类型的假图像。

科学家们使用的GAN程序名为StyleGAN,由泰罗·卡拉斯(Tero Karras)和英伟达(Nvidia)的同事于2019年推出,并于2020年更新为StyleGAN2。它可以拍摄各种人物、地点和事物的真实照片,并以原始图像的方式制作出令人信服的假照片,就像你在网站“这个人不存在”上看到的那样,这是一组非常逼真的假头像。

没错,甘斯根是“深度造假”现象的先锋。关键是,GANs可以生成任何类型的图像,包括假的但看起来很真实的猫和狗图片。

重要的是StyleGAN2可以转移在任意数量的参数,如做鬼脸有肤色浅或深爆头的一个人,或者一只猫的耳朵软盘像狗的或相反的狗的眼睛又大又圆的像猫一样的。换句话说,《StyleGAN 2》能够发挥我们所期待的视觉属性。

作者使用了StyleGAN2,并构建了新的版本StylEX,来处理已经被传统的神经网络分类器程序(在这个例子中,是古老的MobileNet神经网络)分类的图片。该分类器从一个名为“AFHQ”的数据集分类动物的真实图像,该数据集是由Clova AI Research的Yunjey Choi及其同事于2020年推出的。

MobileNet是他们试图用StylEx来撬开的黑盒。

为了开发他们的程序,Lang和团队让StylEx本质上压缩了由MobileNet分类的图像,然后将它们解压成原始图像。然后,新的赝品被反馈到MobileNet,看看MobileNet是否会将相同的类别分配给赝品。

在这个过程中,StylEx可以调整这些参数,这些GAN能够操作的可视属性,并查看这样做是否会抛弃MobileNet。StylEx试图欺骗MobileNet,如果你愿意的话。

他们的想法是,如果StylEx可以创造一个令人信服的假MobileNet接受,然后另一个假MobileNet的仔细分类,然后两者之间的互动带来了一个洞察力,当MobileNet分类图像时,它是基于什么。

正如作者所说,“我们训练GAN来明确地解释分类器。”(“训练”是神经网络的功能首先通过暴露样本数据来开发的阶段。)

图片的压缩版本是StylEx的“StyleSpace”的一部分,即GAN的“解缠绕潜在空间”。StylEx正在预测MobileNet会对什么做出反应。潜在空间是GAN程序中分离图像视觉元素的部分,例如猫的眼睛或狗的舌头。

由于StylEx是通过滑块操作的——实际上,有一些滑块控件可以显示眼睛变大或嘴巴打开或关闭等事情——MobileNet分类器的反应是增加或减少猫或狗的概率分数。这样,StylEx就像一个医学探针一样被用来观察MobileNet的分类会发生什么变化。

换句话说,拨动旋钮就能看出真假有何不同,然后看看它对分类有何影响。

朗和他的同事们称之为“反事实的”实验,,他们写道,“一个声明的形式的输入x x '然后分类器的输出是ỹ而不是x和y ',区别̃是容易解释。”

“容易解释”的概念是它的关键。StylEx的目的是在StyleSpace中识别人类可以理解的东西——“大眼睛”或“摇舌头”——作为解释。这是人工智能向“可解释的”人工智能发展的一部分,人工智能可以打开黑匣子,告诉社会机器如何做出决定。

正如作者所写,

朗和同事们向亚马逊土耳其机器人平台上的工作人员提交了他们的反事实证据,不仅是关于猫和狗的,还包括一系列图像分类,包括人类年龄——“年老”和“年轻”——以及人类性别。他们要求这些人描述照片从真实到虚假的变化。“然后,用户被要求用1到4个词描述他们在图片中看到的最显著的变化。”

您可以通过访问Lang和团队创建的站点亲自尝试,并提供操作示例。

这给我们带来了一个问题:MobileNet分类器知道什么?StylEx程序显示,MobileNet分类器可以重复地对图片中可以分离的一些元素做出反应,比如猫或狗的眼睛大小。

换句话说,分类器神经网络知道一些特征的程度,沿着一个连续的程度,大的或小的,亮的或暗的。

但还有一个问题。正如Lang和他的同事们发现的那样,他们的StylEx程序在创建带有改变特征的赝品时,在每种情况下都会影响分类器处理特定图像的方式。具体这个词是重要的,因为事实证明,MobileNet分类器是相当具体的分类每个图像。

正如作者所写的那样,“这些并不是在许多图像中具有最大平均效果的属性,而是那些对特定图像影响最大的属性。”换句话说,就分类器而言,每个图像都有一个怪癖。或者是一组怪癖。

因此,分类器实际上是在寻找在每个图像中强调的特定的东西,而StylEx程序正在重新创建这些东西。目前还不清楚这些特定于图像的方面是否是知识。它们可以被看作是分类器程序用来将给定的图片与给定的类别相关联的工件。同样不清楚的是,不同图像之间是否存在共性,就像你所期望的那样,如果一个程序真的知道猫或狗的肖像。

如果知识在实践中是关于命名的,那么StylEx提出了一些有趣的问题。命名或分类行为强加了一个二元选择,猫或狗,程序通过关联一个或一组元素来响应,以完成测试。从这个术语的深层意义上说,这是否真的是关于一幅画的知识的一部分,仍然是一个悬而未决的问题。