斯坦福大学(Stanford University)以人为中心的人工智能研究所(Institute for Human-Centered artificial intelligence)发布的第七份全球人工智能状况年度报告为社会提供了一些令人担忧的想法:人工智能技术的成本螺旋式上升,以及对其风险的衡量不力。

HAI周一发布的《人工智能指数2024年度报告》显示,OpenAI的GPT-4等大型语言模型(用于开发其他程序的所谓基础模型)的培训成本正在飙升。

报告的作者写道:“最先进的人工智能模型的培训成本已经达到了前所未有的水平。”“例如,OpenAI的GPT-4使用了价值约7800万美元的计算进行训练,而谷歌的Gemini Ultra在计算上花费了1.91亿美元。”

(“人工智能模型”是人工智能程序的一部分,它包含许多神经网络参数和激活函数,这些是人工智能程序如何运行的关键要素。)

与此同时,报告指出,由于“负责任的人工智能”的衡量标准支离破碎,对此类大型模型的风险衡量标准太少。

报告指出,“负责任的人工智能报告严重缺乏标准化”。“包括OpenAI、谷歌和Anthropic在内的领先开发者,主要针对不同的负责任的人工智能基准测试他们的模型。这种做法使系统比较顶级人工智能模型的风险和局限性的努力变得复杂。”

成本和安全这两个问题都是人工智能蓬勃发展的工业市场的一部分,尤其是通用人工智能,在这个市场上,商业利益和现实世界的部署正在取代几十年来主要由人工智能学者组成的研究社区。

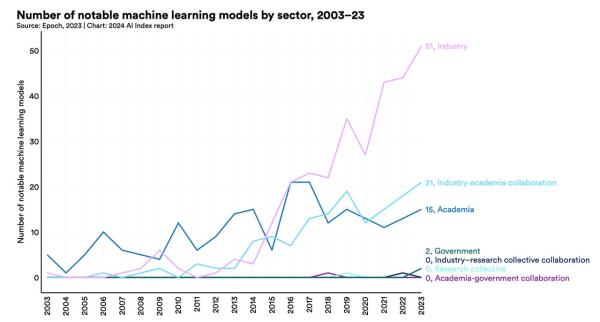

报告指出,2023年“对生成式人工智能的投资激增”,因为该行业产生了51个“引人注目的”机器学习模型,远远超过去年学术界推出的15个模型。“《财富》500强企业的财报电话会议中提到人工智能的次数比以往任何时候都多。”

这份长达502页的报告对每一点都进行了详细阐述。在第一点——培训成本上,该报告的作者与Epoch AI研究机构合作,估算了基础模型的培训成本。报告指出:“人工智能指数的估计证实了人们的怀疑,即近年来模型培训成本大幅增加。”

报告指出,随着越来越大的人工智能模型所需的计算规模越来越大,培训成本也在上升。最初的Google transformer是一种深度学习模型,它引发了gpt和其他大型语言模型的竞争,需要大约10,000千万亿次浮点运算,即10,000万亿次浮点运算。Gemini Ultra的运算速度接近千万亿次浮点运算。

与此同时,评估人工智能程序的安全性——包括透明度、可解释性和数据隐私——是很困难的。有大量的基准测试来评估“负责任的人工智能”,开发人员正在使用其中的许多测试,因此没有一致性。报告指出:“在不同基准上测试模型会使比较变得复杂,因为单个基准具有独特和特质。”“然而,人工智能指数的新分析表明,缺乏负责任的人工智能能力评估的标准化基准报告。”

模型报告的基准表显示了各种各样的基准,但对于负责任的人工智能的基准应该被视为标准,没有达成共识。

“为了改善负责任的人工智能报告,”作者总结道,“就模型开发人员应该持续测试的基准达成共识是很重要的。”

积极的一面是,该研究的作者强调,数据显示人工智能正在对生产力产生积极影响。研究表明:“人工智能使工人能够更快地完成任务,并提高他们的产出质量。”

具体来说,该报告指出,根据微软去年的一份报告,在人工智能的帮助下,专业程序员的项目完成率有所提高。该评论发现,“将使用微软Copilot或GitHub的Copilot(基于法学硕士的提高生产力的工具)的员工的表现与没有使用的员工进行比较,发现Copilot用户完成任务的时间比没有使用人工智能的员工少26%至73%。”

根据其他研究,其他劳工群体的能力也有所提高。哈佛商学院的一份报告发现,“与没有使用人工智能的对照组相比,使用GPT-4的咨询师在选择咨询任务时的工作效率提高了12.2%,速度提高了25.1%,质量提高了40%。”

哈佛大学的这项研究还发现,在完成任务的表现方面,技能较低的咨询师比技能较高的咨询师得到了更大的提升,这表明人工智能有助于缩小技能差距。

“同样,美国国家经济研究局的研究报告称,使用人工智能的呼叫中心座席每小时处理的电话比不使用人工智能的座席多14.2%。”

尽管存在“幻觉”等风险,但使用OpenAI GPT-4的法律专业人士在包括合同起草在内的一系列任务中“在工作质量和时间效率方面”都看到了好处。

然而,生产力也有不利的一面。哈佛大学的另一篇论文发现,专业人才招聘人员使用人工智能会损害他们的表现。更糟糕的是,那些使用更强大的人工智能工具的人,他们的工作表现似乎下降得更厉害。该研究认为,使用“好人工智能”的招聘人员变得自满,过度信任人工智能的结果,而使用“坏人工智能”的招聘人员在审查人工智能输出时更加警惕。

研究报告的作者、哈佛商学院的法布里齐奥·戴尔·阿夸将人工智能使用中的自满现象称为“在方向盘上睡着”。