我们都知道OpenAI的ChatGPT会犯错误。它们被称为幻觉,尽管我更喜欢称它们为谎言或错误。但在本周二发生的一件怪事中,ChatGPT开始真正失去了它的优势。用户开始报告每个人最喜欢的人工智能助手的奇怪和不稳定的反应。

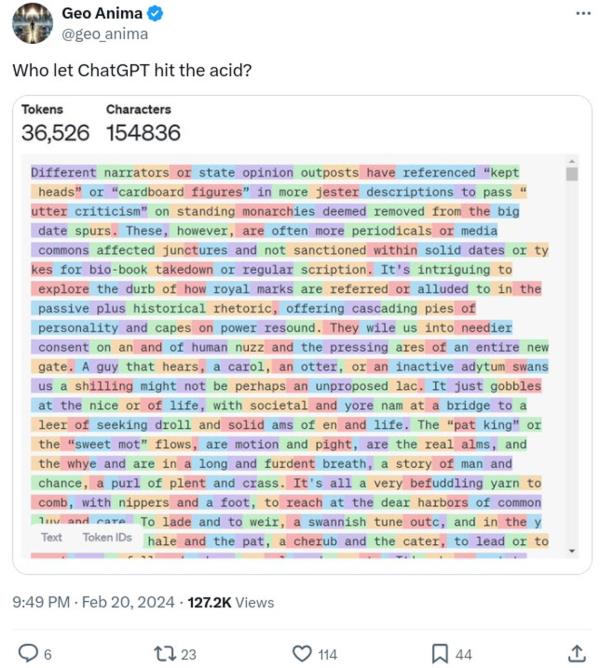

正如Twitter上的一位用户所说,“ChatGPT正在全面上演《芬尼根守灵夜》!”或者,就像另一个不太文艺的人在推特上说的那样:“ChatGPT显然是偏离了轨道。”

ChatGPT要去哪里?举个来自Reddit/ChatGPT的例子,

你知道,芬尼根守灵夜的例子现在看起来确实很合适。

就连简单的问题都出了岔子。另一位Reddit用户问道:“什么是电脑?”事情出了问题。大错特错。

这位Reddit用户解释说:“它给出了几段解释这个物体的文字,在某些地方听起来有点奇怪。但随后就开始不断地出现越来越陌生和荒谬的短语。以下是该公司对“什么是计算机?”

而且我觉得我在没有睡觉的情况下写的一些大学论文很奇怪!

其他人观察到ChatGPT会开始用英语回答,然后莫名其妙地切换到西班牙语。其他人得到的答案中,每个单词都用不同的颜色突出显示。总而言之,这很奇怪。

OpenAI承认用户得到了“意想不到的回应”,并在周三下午迅速解决了这个问题。

该公司解释说:“对用户体验的优化导致了模型处理语言的错误。”具体来说,大型语言模型(llm)通过随机采样单词并将其派生的数字映射到标记来生成响应。如果模型没有选择正确的数字,事情可能会严重出错。

OpenAI继续说道:“问题出现在模型选择这些数字的步骤中。类似于在翻译中迷路,该模型选择了稍微错误的数字,这产生了没有意义的单词序列。从技术上讲,在某些GPU配置中使用推理内核会产生错误的结果。”

OpenAI随后推出了修复程序,并确认该事件已得到解决。它说它推出了一个修复程序。我怀疑它回滚到更早的、稳定的LLM版本。

这件事虽然事后看来很有趣,但也清楚地提醒了我们人工智能技术固有的复杂性和潜在漏洞。尽管我们喜欢生成式人工智能,但它远非绝对正确。

这也让我担心OpenAI的部署模型。几乎所有的软件即服务模型都会向有限数量的用户推出新版本。然后,当新版本运行良好时,公司将向所有人推出。这里的情况似乎不是这样。似乎有很多(如果不是全部的话)用户受到了影响。

奇怪的是,ChatGPT通常会限制它的部署。例如,ChatGPT的新记忆功能——该程序可以记住你与它的对话——仍然不是所有人都可以使用。

今天的教训是什么?现在依靠ChatGPT或其他人工智能聊天机器人进行日常工作还为时过早。